Nvidia đưa chip mới vào sản xuất toàn diện, hiệu năng AI tăng gấp 5 lần

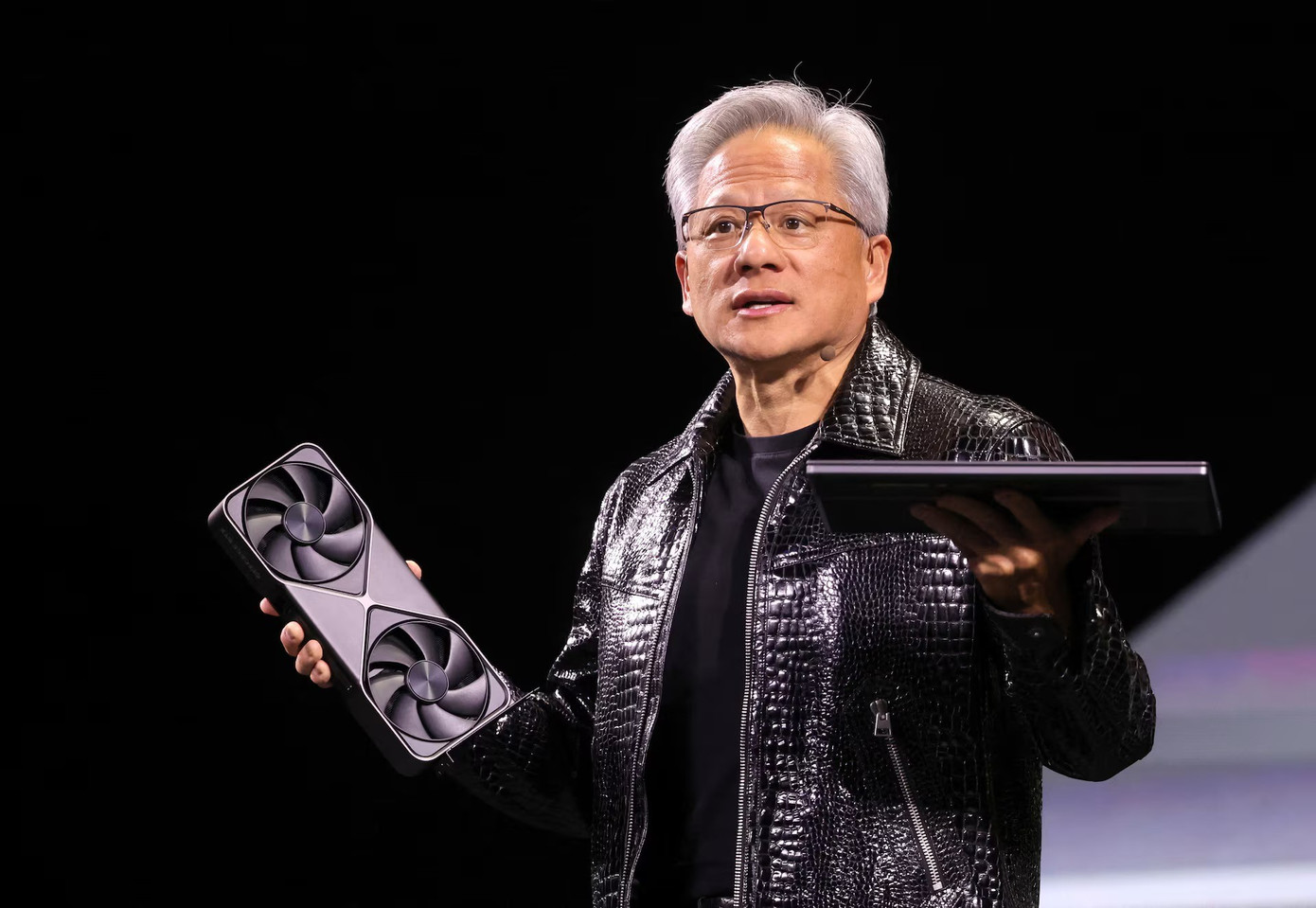

Tại Triển lãm điện tử tiêu dùng (CES) 2026 diễn ra ở Las Vegas, Mỹ, Giám đốc điều hành Nvidia Jensen Huang cho biết thế hệ chip tiếp theo của hãng đã chính thức bước vào giai đoạn sản xuất toàn diện, đánh dấu bước tiến lớn về năng lực tính toán cho trí tuệ nhân tạo (AI) trong bối cảnh cạnh tranh toàn cầu ngày càng gay gắt.

Theo ông Huang, các chip mới có khả năng cung cấp năng lực tính toán AI cao gấp 5 lần so với thế hệ trước khi phục vụ chatbot và các ứng dụng AI. Dòng chip này dự kiến sẽ được tung ra thị trường vào cuối năm nay và hiện đã được các công ty AI thử nghiệm trong phòng thí nghiệm của Nvidia.

Tâm điểm trong các công bố lần này là nền tảng Vera Rubin, gồm 6 loại chip riêng biệt của Nvidia. Máy chủ chủ lực của nền tảng này được trang bị 72 bộ xử lý đồ họa (GPU) và 36 bộ xử lý trung tâm (CPU) thế hệ mới. Theo Nvidia, các hệ thống Vera Rubin có thể được kết nối thành các “pod” với hơn 1.000 chip, giúp cải thiện hiệu suất tạo “token”, đơn vị cơ bản của hệ thống AI lên gấp 10 lần, qua đó nâng cao tốc độ và hiệu quả xử lý.

Để đạt được bước nhảy vọt về hiệu năng, chip Rubin sử dụng một dạng dữ liệu độc quyền. Nvidia kỳ vọng công nghệ này sẽ được ngành công nghiệp chấp nhận rộng rãi trong tương lai. “Đây là cách chúng tôi đạt được mức cải thiện hiệu năng rất lớn, dù số lượng transistor chỉ tăng 1,6 lần”, ông Huang nhấn mạnh.

Giám đốc điều hành Nvidia Jensen Huang cho biết thế hệ chip tiếp theo của hãng đã chính thức bước vào giai đoạn sản xuất toàn diện.

Dù đang thống lĩnh thị trường huấn luyện mô hình AI, Nvidia phải đối mặt với sự cạnh tranh ngày càng lớn trong khâu triển khai ứng dụng AI đến người dùng cuối. Đối thủ không chỉ đến từ các hãng bán dẫn truyền thống như AMD, mà còn từ chính khách hàng lớn như Google (Alphabet) - doanh nghiệp đang tự phát triển chip AI để giảm phụ thuộc vào Nvidia.

Trong bài phát biểu, ông Huang dành nhiều thời gian nói về khả năng của chip mới trong việc phục vụ các ứng dụng AI quy mô lớn, bao gồm việc tích hợp công nghệ lưu trữ mới mang tên “context memory storage”, giúp chatbot phản hồi nhanh và mượt hơn trong các cuộc hội thoại dài.

Bên cạnh đó, Nvidia cũng giới thiệu thế hệ bộ chuyển mạch mạng mới sử dụng công nghệ co-packaged optics, cho phép kết nối hàng nghìn máy tính thành một hệ thống thống nhất. Công nghệ này được xem là đối thủ trực tiếp của các giải pháp do Broadcom và Cisco Systems cung cấp.

Nvidia cho biết CoreWeave sẽ là một trong những doanh nghiệp đầu tiên triển khai hệ thống Vera Rubin. Ngoài ra, các “ông lớn” công nghệ như Microsoft, Amazon, Oracle và Alphabet cũng được kỳ vọng sẽ sớm áp dụng nền tảng chip mới này.

Ngoài phần cứng, Nvidia còn công bố phần mềm mới hỗ trợ xe tự lái ra quyết định và lưu lại dữ liệu để kỹ sư phân tích. Đáng chú ý, Nvidia sẽ mở rộng phát hành phần mềm Alpamayo, đồng thời công khai cả dữ liệu huấn luyện, nhằm tăng tính minh bạch và độ tin cậy cho các nhà sản xuất ô tô.

Liên quan đến chiến lược dài hạn, Nvidia gần đây đã chiêu mộ nhân sự và công nghệ từ startup Groq, bao gồm các chuyên gia từng tham gia thiết kế chip AI cho Google. Theo ông Huang, thương vụ này sẽ không ảnh hưởng đến hoạt động cốt lõi, nhưng có thể mở đường cho các sản phẩm mới trong tương lai.

Trong khi đó, Nvidia cũng đang chịu sự chú ý lớn về hoạt động kinh doanh tại Trung Quốc. Ông Huang xác nhận nhu cầu đối với dòng chip H200 tại thị trường này vẫn rất mạnh. Giám đốc tài chính Colette Kress cho biết Nvidia đã nộp đơn xin giấy phép xuất khẩu chip sang Trung Quốc và đang chờ phê duyệt từ chính phủ Mỹ cùng các cơ quan liên quan.

Những công bố tại CES cho thấy Nvidia đang nỗ lực củng cố vị thế dẫn đầu trong lĩnh vực AI, đồng thời chuẩn bị cho cuộc cạnh tranh ngày càng quyết liệt trên thị trường chip toàn cầu.