Cambridge Analytica đã biến nút “like” Facebook thành công cụ chính trị thế nào?

Thuật toán được sử dụng trong vụ rò rỉ dữ liệu của Facebook đã vơ vét gần như mọi thông tin cá nhân của người dùng – từ xu hướng tình dục, màu da, giới tính cho tới trí thông minh và những tổn thương tâm lý từ thuở nhỏ.

Bài viết là quan điểm của Carole Cadwalladr và Emma Graham-Harrison, các tay viết của tờ báo Anh uy tín The Guardian.

Thuật toán đứng đằng sau vụ rò rỉ thông tin của Facebook thực sự rất khó để tin là có thật. Nó vơ vét mọi thứ chỉ từ những nút "like" mà người dùng Facebook vẫn hay sử dụng, ngay cả những thông tin cá nhân nhạy cảm như xu hướng tình dục, màu da, giới tính cho tới trí thông minh và những tổn thương tâm lý từ thuở nhỏ.

Vài chục nút "like" cũng là quá đủ để thuật toán này có thể dự đoán xem người dùng sẽ bỏ phiếu cho Đảng nào, giới tính của họ là gì, họ có xu hướng quan hệ đồng giới hay khác giới, bố mẹ của họ có chung sống hòa thuận với nhau hay không, họ có từng bị lạm dụng hay có nguy cơ bị lạm dụng hay không,...và nhiều hơn thế nữa. Đặc biệt hơn, nó có thể làm điều này mà không cần phải phân tích từng tin nhắn, bài đăng, cập nhật trạng thái, hình ảnh hay những thông tin khác mà Facebook nắm giữ.

Một số kết quả nghe có vẻ giống kết quả của một cuộc điều tra trực tuyến hơn là một bản phân tích dữ liệu phức tạp: "like" một trang chiến dịch tranh cử khác với việc dán áp phích lên cửa sổ.

Nhưng 5 năm trước, các nhà nghiên cứu tâm lý học đã chỉ ra rằng những đặc điểm tính cách phức tạp có thể được rút ra từ một vài các kiểu mẫu vô hình đối với người đang quét qua các trang cá nhân. Chỉ một vài nút "like" tưởng như hoàn toàn ngẫu nhiên có thể là cơ sở để định hình những cá tính ẩn sâu bên trong.

Ví dụ, những người thích món khoai tây xoắn thường thông minh hơn; yêu thích mèo Hello Kitty cũng là đặc điểm để xác định quan điểm chính trị, hay "Cảm thấy hoang mang khi ngủ dậy" có liên kết với xu hướng tình dục.

Đây chỉ là một số ví dụ về mối quan hệ của những thứ tưởng chừng chẳng liên quan đến nhau được đăng trên tạp chí Proceedings of the National Academy trong năm 2013. "Một số người dùng đã vô tình tiết lộ phần nào tính cách của mình chỉ bằng những nút "like". Chẳng hạn, gần 5% người dùng được xếp vào mục ‘đồng tính nam' có liên kết với các nhóm của người đồng tính, ví dụ như chiến dịch No H8", trong nghiên cứu viết.

Các nhà nghiên cứu, Michal Kosinski, David Stillwell và Thore Graepel đã thấy những tiềm năng không mấy tốt đẹp của nghiên cứu và đặt ra những nghi vấn về quyền riêng tư. Ở thời điểm đó, việc người dùng "like" một cái gì đó được thiết lập mặc định ở chế độ công khai.

Họ nói: "Khả năng dự đoán các thuộc tính cá nhân từ những hồ sơ hành vi kỹ thuật số có thể có những ý nghĩa tiêu cực, bởi vì nó có thể dễ dàng được áp dụng trên một lượng lớn người dùng mà không được họ đồng ý hay thậm chí nhận ra. Các công ty thương mại, các tổ chức chính phủ, hay thậm chí là bạn bè trên Facebook của bạn có thể dùng phần mềm để dự đoán các thuộc tính như trí thông minh, xu hướng tình dục hay quan điểm chính trị mà bạn vốn không hề có ý định chia sẻ".

Đối với một số người, đây là một tiềm năng kinh doanh rất lớn. Đầu năm 2014, Giám đốc điều hành Alexander Nix của Cambridge Analytica đã ký hợp đồng với một trong những đồng nghiệp của Kosinski tại Cambridge, giảng viên Aleksandr Kogan về một dự án thương mại tư nhân, tách biệt hoàn toàn với những công việc của Kogan tại trường đại học.

Aleksandr Kogan, người đứng sau ứng dụng đã "gây đại họa" cho Facebook

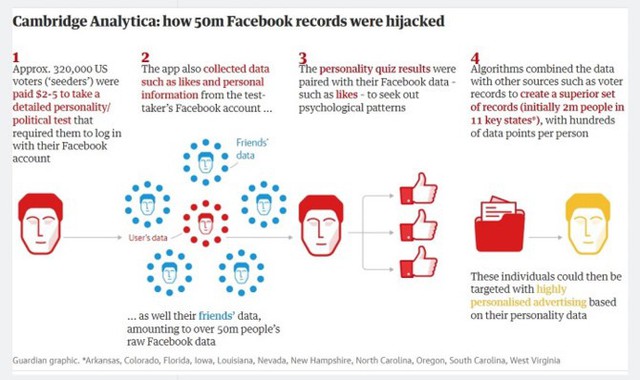

Kogan đã tạo ra một ứng dụng gồm các câu hỏi về thông tin cá nhân, và Cambridge Analytica sẽ trả tiền cho những người tham gia trả lời, đồng thời quảng cáo ứng dụng này trên nhiều nền tảng, như Mechanical Turk của Amazon.

Ứng dụng ghi lại các kết quả của mỗi câu hỏi, thu thập dữ liệu của tài khoản Facebook người thực hiện, và thậm chí còn chiết xuất dữ liệu của cả bạn bè của tài khoản đó. Các kết quả sẽ được so sánh với dữ liệu Facebook của những người tham gia trả lời để tìm ra điểm chung và từ đó xây dựng thuật toán để dự đoán kết quả của những người dùng Facebook khác. Các trang cá nhân sẽ vừa trở thành nơi để thử nghiệm công thức, vừa là thứ giúp cho thuật toán trở nên đáng giá về mặt chính trị.

Để có thể tham gia trả lời, người dùng phải có một tài khoản Facebook và là công dân Mỹ đã đủ điều kiện để bỏ phiếu, nên hàng chục triệu trang cá nhân sẽ có sức ảnh hưởng rất lớn đến cuộc bầu cử. Chỉ từ 1.000 tài khoản "hạt giống", các nhà nghiên cứu đã thu về được hơn 160.000 hồ sơ, và con số cứ thế tăng theo cấp số nhân.

Về lý thuyết, hành động này của Kogan là vi phạm quy tắc của Facebook, do Kogan không có quyền thu thập và sử dụng dữ liệu dưới hình thức thương mại. Facebook chỉ cho phép Kogan sử dụng vào mục đích nghiên cứu.

Và mặc dù ở thời điểm đó Facebook cho phép các ứng dụng thu thập dữ liệu của bạn bè, nó chỉ được phép sử dụng trong phạm vi của chính nền tảng Facebook để tăng tính tương tác. Bán những dữ liệu đó, hay sử dụng chúng vào các mục đích khác – bao gồm mục đích tiếp thị chính trị của Cambridge Analytica – bị cấm tuyệt đối.

Ngoài ra, hành động này của Kogan cũng đã vi phạm các bộ luật bảo vệ dữ liệu của Vương quốc Anh – cấm mua bán và sử đụng dữ liệu cá nhân khi chưa được chủ nhân của chúng cho phép. Nó cũng bao gồm các vụ việc khi đồng thuận vào một mục đích nhưng dữ liệu lại được dùng cho mục đích khác.

Các tài khoản tham gia trả lời câu hỏi đã đồng ý với điều khoản của ứng dụng của Kogan, bao gồm việc thu thập dữ liệu của họ, và các điều khoản mặc định của Facebook cũng cho phép ứng dụng thu thập dữ liệu của bạn bè, trừ khi họ thiết lập lại trong tùy chọn bảo mật. Tuy nhiên, không ai trong số họ đồng ý với việc dữ liệu của họ bị lạm dụng để tạo ra một công cụ tiếp thị chính trị, hay được đặt trong cơ sở dữ liệu của các chiến dịch tranh cử.

Tuy nhiên, Kogan lại khẳng định mình không làm sai, khi anh đã thực hiện thay đổi mục đích của ứng dụng từ "nghiên cứu" sang "thương mại", nhưng Facebook không có ý kiến gì.

Facebook cũng khẳng định đây không phải là một vụ rò rỉ thông tin. Phó Chủ tịch Paul Grewal chia sẻ: "Bảo vệ thông tin của mọi người là trọng tâm của những gì chúng tôi đã và đang làm, và chúng tôi đòi hỏi những điều tương tự từ những người vận hành các ứng dụng trên Facebook. Nếu những báo cáo này là đúng, thì đó là các quy tắc của chúng tôi đã bị lạm dụng [chứ không phải rò rỉ thông tin]".

Quy mô của việc Cambridge Analytica thu thập dữ liệu lớn đến nỗi nó đã tự động tắt tính năng thu thập của ứng dụng. Nhưng Kogan đã nói với một đồng nghiệp rằng anh "đã nói chuyện với một kỹ sư" để được loại bỏ sự giới hạn, và chỉ trong vòng 1-2 ngày, ứng dụng đã hoạt động lại bình thường.

Chỉ trong vài tháng, Kogan và Cambridge Analytica đã có một cơ sở dữ liệu gồm hàng chục triệu cử tri Mỹ, từ đó phân tích tính cách và quan điểm chính trị bằng thuật toán mà họ đã phát triển. Từ đó, họ sẽ có thể chọn những mục tiêu nhất định và tạo ra những tin nhắn hấp dẫn với họ - một hình thức tiếp cận chính trị còn được gọi là "micro-targetting".

Facebook được cho là đã biết về vụ việc này từ cách đây 3 năm, và tuy họ đã thực hiện những sự thay đổi để ngăn chuyện này không tái diễn trong tương lai, việc họ hoàn toàn không công bố vụ việc cho người dùng và các cơ quan chức trách đã tạo nên một làn sóng giận dữ và "tẩy chay" trên toàn thế giới. Giá cổ phiếu của Facebook liên tục giảm, hàng chục tỷ USD giá trị vốn hóa thị trường "bốc hơi" và bản thân CEO Mark Zuckerberg cũng mất hàng tỷ USD chỉ sau vài ngày.

Mãi đến ngày 22/3, tức gần 1 tuần sau khi vụ bê bối bị vỡ lở, Mark Zuckerberg mới chính thức lên tiếng về vụ việc và thừa nhận mình đã mắc sai lầm. Tuy nhiên, lời xin lỗi của anh bị coi là "chưa thành khẩn" và chưa đủ để lấy lại lòng tin của người dùng.

Mark Zuckerberg cũng sẽ phải giải trình trước Quốc hội Mỹ và Quốc hội Anh trong thời gian tới.